阿里最新开源视频生成模型Wan 2.1现已支持Windows本地部署!这款完全免费的AI大模型可在普通家用电脑上离线运行,生成效果媲美主流开源模型,在VBench榜单表现优异,甚至超越部分闭源模型。无论是文字转视频还是图片转动态画面,都能轻松实现。

通过ComfyUI工作流接入Wan 2.1模型,用户无需复杂配置即可体验AI视频生成乐趣。该方案部署流程简单快捷,特别适合普通用户快速上手。下面将详细介绍如何在本地安装并使用Wan 2.1来生成AI视频,让您轻松开启创意视频制作之旅。Comfyui(2020web.cn)保姆级教程

1.软件准备

安装Comfyui软件:https://www.2020web.cn/894.html

(已安装,可跳过此步)

2.安装模型(wan2.1)

模型下载到根目录:ComfyUI-aki-v1.6ComfyUImodelsdiffusion_models

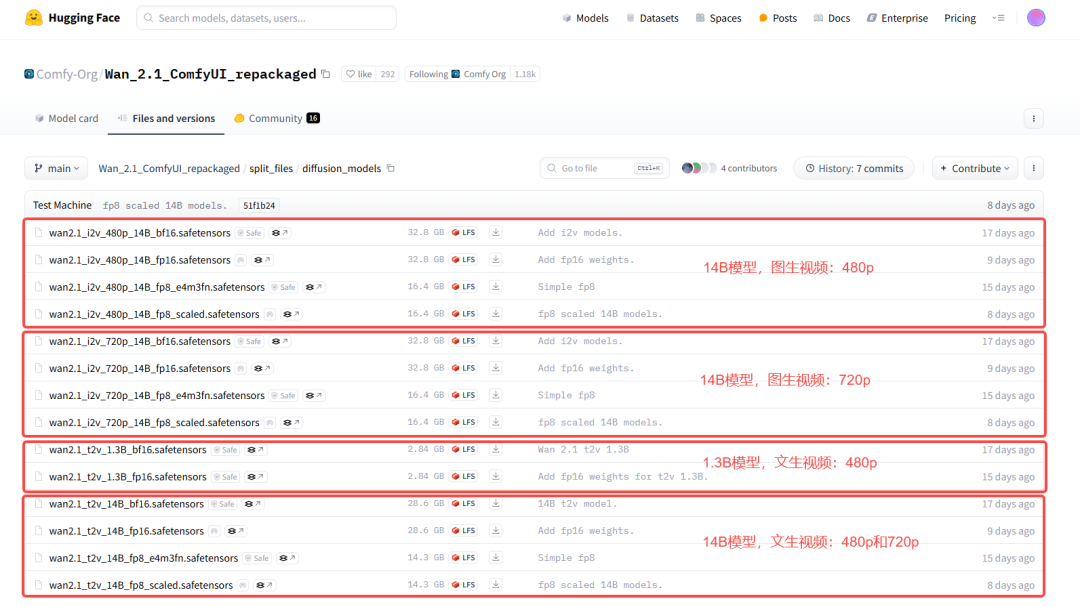

模型(文章尾部有下载):https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files/diffusion_models

同时,每个尺寸的模型下也有多个模型,根据生成质量的优劣,按照如下原则选择(质量等级从高到低):

fp16 > bf16 > fp8_scaled > fp8_e4m3fn

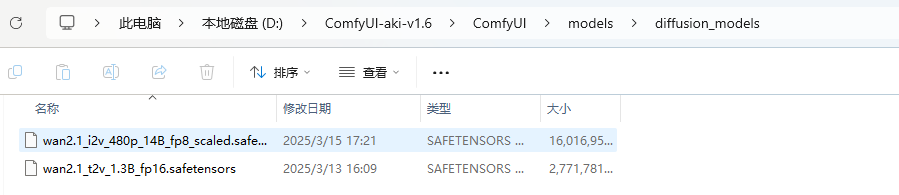

结合自己的显存大小,我选择这两个模型下载到本地:

- 文生视频:

wan2.1_t2v_1.3B_fp16.safetensors - 图生视频:

wan2.1_i2v_480p_14B_fp8_scaled.safetensors

然后移到ComfyUI整合包的ComfyUImodelsdiffusion_models目录下面。

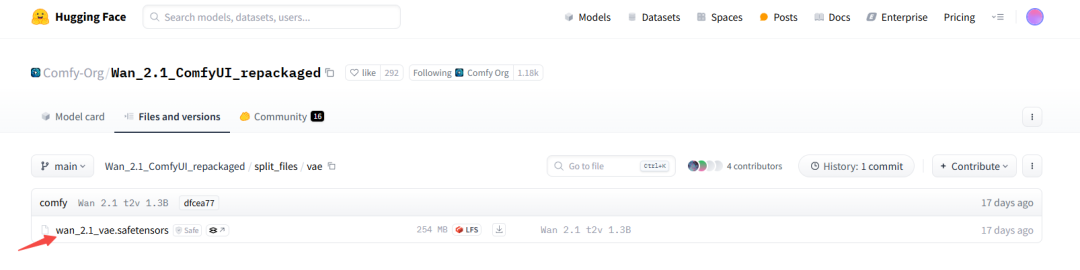

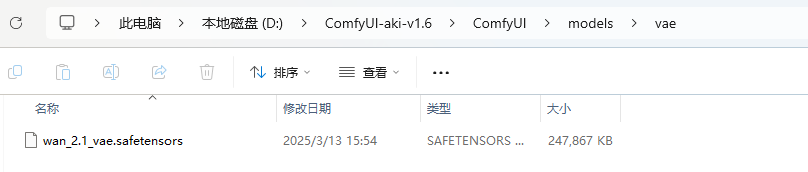

3.vae下载安装

打开下面这个页面,下载vae:

https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files/vae(尾部有合集下载)

下载到本地后,移到ComfyUI整合包的ComfyUImodelsvae目录下。

4.安装clip_vision:

打开下面这个页面,下载clip_vision:

(尾部有合集下载)https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files/clip_vision

下载到本地后,移到ComfyUI整合包的ComfyUImodelsclip_vision目录下。

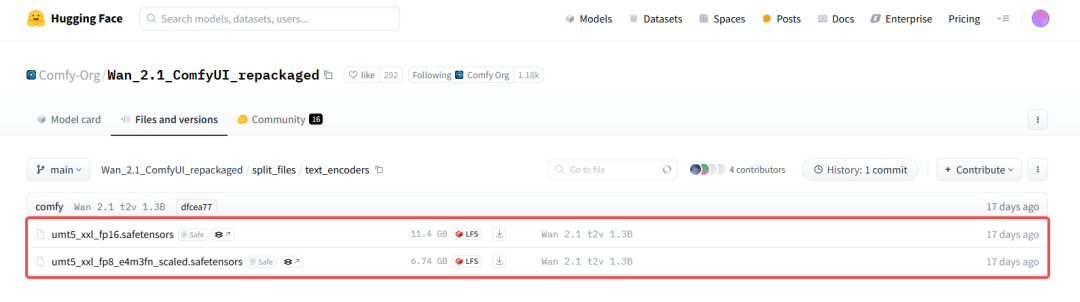

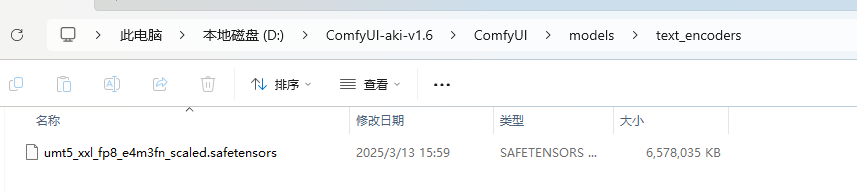

5.text_encoders下载

打开下面这个页面,下载text_encoders:

(尾部有合集下载)https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/split_files/text_encoders

- 如果显存 >= 12G,选择第一个text_encoder

下载 - 如果显存 < 12G,选择第二个text_encoder

下载

我下载一个小一点的,然后移到ComfyUI整合包的ComfyUImodelstext_encoders目录下。

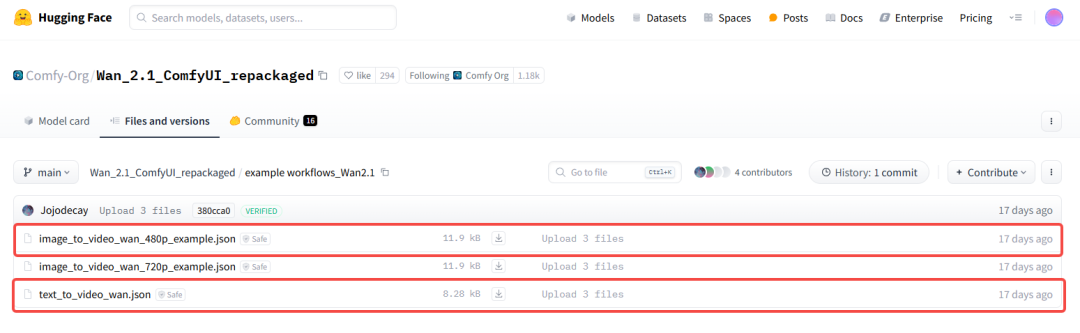

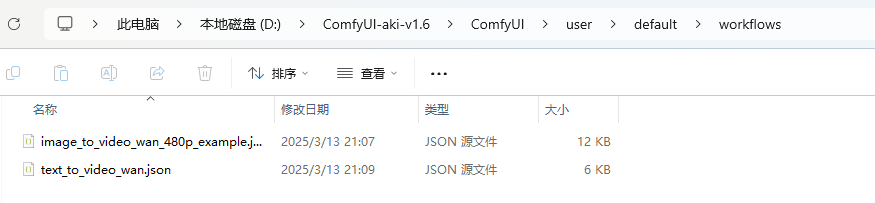

6、工作流下载

打开下面这个页面,下载工作流:

(尾部有合集下载)https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/tree/main/example%20workflows_Wan2.1

我们根据第三步下载的diffusion_model,相对应地选择第一个和第三个工作流下载:

然后移到ComfyUI整合包的ComfyUIuserdefaultworkflows目录下:

工作流示例: