一、checkpoints大模型

1、SD15版本大模型

1.SD15官方基础大模型:v1-5-pruned-emaonlysafetensors

出图效果差,一般不用来作图。主要用来模型训练、模型融合,出图演示。

2.SD15官方基础大模型

模型地址:v1-5-prunedckpt

3.SD15官方基础修复大模型

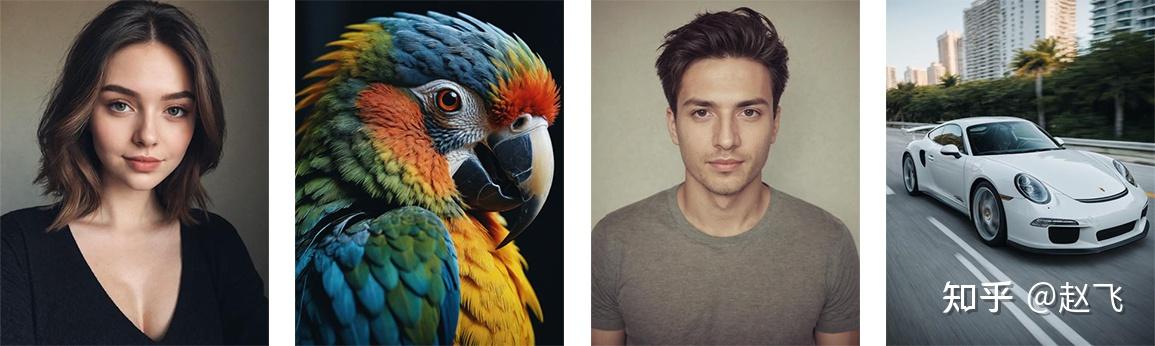

4.写实大模型:

模型地址:realisticVisionV51_v51VAEsafetensors

模型地址:Realistic_Vision_V51-inpaintingsafetensors修复版本

较火的写实模型,制作真是照片效果。

5 .适合动漫风格的大模型

模型地址:revAnimated_v122EOLsafetensors

6.国风大模型

7.Dreamshape LCM大模型

模型地址:LCM_Dreamshaper_v7_4ksafetensors

LCM全称Latent Consistency Models(潜在一致性模型),可以通过几步推理合成高分辨率图像。

8.迪士尼皮克斯风格大模型

模型地址:disneyPixarCartoon_v10safetensors

9.麦橘写实大模型

模型地址:majicmixRealistic_v7safetensors

适合制作亚洲漂亮女孩图片。

10.美娜混合大模型

模型地址:meinamix_meinaV11safetensors

11 虚幻写实大模型

12.万象熔炉大模型

模型地址:AnythingXL_v50safetensors

适合制作二次元图像。

2、SDXL版本大模型

1.SDXL10官方基础模型

出图效果差,一般不用来作图。主要用来模型训练、模型融合,出图演示。

2.SDXL10官方refiner模型

模型地址:sd_xl_refiner_10safetensors

官方sd_xl_base_10safetensors模型配套的refiner,主要用来演示操作。后续的SDXL基本不需要使用refiner模型。

3.SDXL写实大模型

模型地址:realvisxlV40_v40Bakedvaesafetensors

4.SDXL turbo模型

模型地址:sd_xl_turbo_10_fp16safetensors

Turbo模型 是一种快速生成文本到图像的模型。

5.SDXL lightning模型

模型地址:sdxl_lightning_4stepsafetensors

SDXL-Lightning 是一种闪电般快速的文本到图像生成模型。它可以通过几个步骤生成高质量的 1024px 图像。

6.巨无霸写实模型V8

模型地址:juggernautXL_v8Rundiffusionsafetensors

巨无霸写实模型V9:juggernautXL_v9Rundiffusionphoto2safetensors

7.亚洲人像模型

模型地址:sdxl10ArienmixxlAsian_v45Prunedsafetensors

8.动漫主题模型

模型地址:animagineXLV31_v31safetensors

9.虚幻写实大模型:

模型地址:dreamshaperXL_lightningDPMSDEsafetensors

模型地址:dreamshaperXL_alpha2Xl10safetensors

3、SD3.0版本大模型

官方SD3大模型

不含文本编码器,仅包含 MMDiT 和 VAE 权重,SDNext将根据需要自动加载 CLiP 模型

4、SD Audio版本模型

音频生成模型

模型地址:https://pan.baidu.com/s/1EhB6QE4epY-NgzyTiYjUFg?pwd=3jif

5、FLUX版本大模型

模型地址:FLUXdev压缩版本:flux1-dev-fp8safetensors

二、Unet模型

1、SD15版本Unet模型

2、SDXL版本Unet模型

3、FLUX版本Unet模型

模型地址:flux1-devsafetensors

模型地址:flux1-fill-devsafetensors

三、VAE模型

1、SD15版本VAE模型模型地址:

- vae-ft-ema-560000-ema-prunedckpt

- vae-ft-mse-840000-ema-prunedckpt

- color101VAE_v1safetensors

- vae-originalckpt

适合漫画风格的VAE:kl-f8-anime2ckpt

2、SDXL版本VAE模型模型地址:

SDXL官方配套VAE模型

模型地址:sdxl_vaesafetensors

模型地址:vae_transparent_decodersafetensors

3、FLUX版本VAE模型

模型地址:aesafetensors

4、其他VAE模型

通义万相WAN模型配套VAE模型地址:wan_21_vaesafetensors

四、Clip文本编码模型

- stableDiffusion3SD3_textEncoderClipGsafetensors

- stableDiffusion3SD3_textEncoderClipLsafetensors

- stableDiffusion3SD3_textEncoderT5E4m3fnsafetensors

- t5_basesafetensors

- clip_lsafetensors

- t5xxl_fp8_e4m3fnsafetensors

- clip-vit-large-patch14safetensorssafetensors

- t5xxl_fp16safetensors

- umt5_xxl_fp8_e4m3fn_scaledsafetensors

五、clip_vision图像编码模型

- CLIP-ViT-bigG-14-laion2B-39B-b160ksafetensors

- CLIP-ViT-H-14-laion2B-s32B-b79Ksafetensors

- sigclip_vision_patch14_384safetensors

- clip_vision_hsafetensors

六、LoRA模型

1、SD15版本LoRA模型

- 工笔画风格LoRA:MoXinV1safetensors

- 盲盒风格LoRA:blindbox_v1_mixsafetensors

- 汉服风格LoRA:https://pan.baidu.com/s/1zIcU8nRzD8ffye4trM0lBA?pwd=i4ey

- 添加细节LoRA:more_detailssafetensors

- 霓虹效果LoRA:CyberPunkAIsafetensors

- 龙元素LoRA:dragon_real_base_V1safetensors

- 科幻风格LoRA:XSArchi_127safetensors

- 宫崎骏风格LoRA:Miyazakisafetensors

- 快速生成LoRA:pcm_sd15_smallcfg_2step_convertedsafetensors

2、SDXL版本LoRA模型

- lightningLoRA模型:sdxl_lightning_4step_lorasafetensors

SDXL-Lightning 是一种闪电般快速的文本到图像生成模型。它可以通过几个步骤生成高质量的 1024px 图像

- neo_iconsafetensors

- cutedoodle_XL-000012safetensors

- outdoor-product-photography-SDXLsafetensors

- xl_more_art-full_v1safetensors

- Designer_BlindBox-000015safetensors

- detailedsafetensors

3、FLUX版本LoRA模型

- Brand_Marks_-_Logo_Icon_Symbolsafetensors

- cartoon_logo_flux_lorasafetensors

- CuteLogoMakersafetensors

- Graffiti_Logo_Style_Fluxsafetensors

- logomaker1024-000008safetensors

- VibrantTech3D_v1safetensors

- CharacterDesign-FluxV2safetensors

- FluxMythP0rtr4itStylesafetensors

- aidmaRealisticPeoplePhotograph-FLUX-V02safetensors

- OB拍立得人像摄影Instant camera portrait photography V20safetensors

- zyd232_Hanfu_Flux1D_Ming_PiFeng_v1_0safetensors

七、IC-LoRA模型

In-Context LoRA(IC-LoRA)的核心概念是将条件图像和目标图像拼接成一张合成图像,同时使用自然语言来定义任务。这种方法可以无缝适应各种应用。

1、SD15版本IC-LoRA模型

2、SDXL版本IC-LoRA模型

3、FLUX版本IC-LoRA模型

- Migration_Lora_clothsafetensors功能:持续的衣物迁移 高精度地在参考图像之间传递服装风格。

八、LyCORIS模型

1、SD15版本LyCORIS模型

- 微缩世界LyCORIS模型:miniature_V1safetensors

九、Embedding嵌入式模型

1、SD15版本Embedding模型

- 负嵌入Embedding:EasyNegativesafetensors

使用率极高的一款负面提示词 embedding 模型,可以有效提升画面的精细度。适合动漫大模型。

2 负嵌入Embedding:ng_deepnegative_v1_75tpt

适合实写大模型

3 正嵌入年龄滑块Embedding:

- AS-Adultpt

- AS-Adult-negpt

- AS-Elderlypt

- AS-MidAgedpt

- AS-YoungerV2pt

- AS-YoungestV2pt

- AS-YoungV2pt

- AS-YoungV2-negpt

十、Hypernetwork超网络模型

1、SD15版本Hypernetwork模型

十一、Controlnet模型

1、SD15版本Controlnet模型

- 重上色Controlnet模型:ioclab_sd15_recolorsafetensors

- ip-adapter Controlnet模型:ip-adapter_sd15pth

- t2iadapterControlnet模型:

- t2iadapter_color_sd14v1pth

- t2iadapter_sketch_sd15v2pth

- t2iadapter_style_sd14v1pth

- control_v11e_sd15_ip2ppth

- control_v11e_sd15_shufflepth

- control_v11f1e_sd15_tilepth

- control_v11f1p_sd15_depthpth

- control_v11p_sd15_cannypth

- control_v11p_sd15_inpaintpth

- control_v11p_sd15_lineartpth

- control_v11p_sd15_mlsdpth

- control_v11p_sd15_normalbaepth

- control_v11p_sd15_openposepth

- control_v11p_sd15_scribblepth

- control_v11p_sd15_segpth

- control_v11p_sd15_softedgepth

- control_v11p_sd15s2_lineart_animepth

2、SDXL版本Controlnet模型

- control_instant_id_sdxlsafetensors

- ip-adapter_instant_id_sdxlbin

- xinsircontrolnet-openpose-sdxl-10safetensors

- control-lora-canny-rank256-SDXLsafetensors

- control-lora-depth-rank256-SDXLsafetensors

- control-lora-recolor-rank256-SDXLsafetensors

- control-lora-sketch-rank256-SDXLsafetensors

- t2i-adapter-canny-sdxl-10safetensors

- t2i-adapter-depth-midas-sdxl-10safetensors

- t2i-adapter-depth-zoe-sdxl-10safetensors

- t2i-adapter-lineart-sdxl-10safetensors

- t2i-adapter-openpose-sdxl-10safetensors

- t2i-adapter-sketch-sdxl-10safetensors

- ip-adapter-plus_sdxl_vit-hsafetensors

- ip-adapter_sdxlsafetensors

- CN-anytest_v4-margedsafetensors

3、FLUX版本Controlnet模型

- ip_adaptersafetensors

- flux-canny-controlnet-v3safetensors

- FLUX1-dev-Controlnet-Inpainting-Betalsafetensors

- flux_dev_openpose_controlnetsafetensors

十二、sam模型

1、sam模型

2、sam2模型

Segment Anything Model 2(SAM 2)是解决图像和视频中可提示的视觉分割问题的基础模型。

十三、其他语义分割模型

一个与图像解析或语义分割相关的模型文件,通常用于人体解析、场景解析等任务。它可能是基于 ParseNet 或其他类似架构的预训练模型。

十四、groundingdino模型

十五、GFPGAN模型

十六、Codeformer

十七、面部检测模型

十八、SVD模型

Stable Video Diffusion (SVD) 模型系列,是由 Stability AI 开发的一种基于扩散模型(Diffusion Model)的视频生成模型,能够从单张图像生成高质量的视频。

- svd_xtsafetensors

- stable-video-diffusion-img2vid-xt-1-1huggingface项目文件包

十九、Zero123模型

Stable Zero123 是由 Stability AI 开发的一种基于 Zero123 技术的图像生成模型,专门用于从单张图像生成高质量的多视角 3D 物体视图

二十、layerdiffuse模型

1、SD15版本layerdiffuse模型

3layer_sd15_vae_transparent_decodersafetensors

2、SDXL版本layerdiffuse模型

- layer_xl_bg2blesafetensors

- layer_xl_bgble2fgsafetensors

- layer_xl_fg2blesafetensors

- layer_xl_fgble2bgsafetensors

- layer_xl_transparent_attnsafetensors

- layer_xl_transparent_convsafetensors

二十一、antelopev2模型

二十二、brushnet模型

BrushNet 是一种基于扩散的文本引导图像修复模型,可以即插即用地加入任何预训练的扩散模型中。

- random_masksafetensors

- segmentation_masksafetensors

- diffusion_pytorch_modelsafetensors对应的配置文件:configjson

二十三、Fooocus模型

二十四、IPAdapter模型

1、SD15版本IPAdapter模型

- ip-adapter_sd15safetensors

- ip-adapter_sd15_light_v11bin

- ip-adapter_sd15_vit-Gsafetensors

- ip-adapter-full-face_sd15safetensors

- ip-adapter-plus_sd15safetensors

- ip-adapter-plus-face_sd15safetensors

2、SDXL版本IPAdapter模型

- ip-adapter_sdxlsafetensors

- ip-adapter_sdxl_vit-hsafetensors

- ip-adapter-plus_sdxl_vit-hsafetensors

- ip-adapter-plus-face_sdxl_vit-hsafetensors

3、FLUX版本IPAdapter模型

二十五、LaMa模型

基于傅里叶卷积的分辨率稳健大型掩模修复

二十六、MAT模型

二十七、Gligen模型

GLIGEN 在现有的预训练文本到图像扩散模型的基础上构建并扩展其功能,使其能够根据参考输入进行条件生成。

二十八、UnCLIP模型

UnCLIP 的主要功能是通过文本描述生成高质量的图像。它结合了 CLIP 的文本-图像对齐能力和扩散模型(Diffusion Model)的图像生成能力,能够生成与文本描述高度匹配的图像

二十九、llava模型

三十、wd-v1-4模型与模型字典

- wd-v1-4-convnextv2-tagger-v2onnx

- wd-v1-4-convnextv2-tagger-v2csv字典

- wd-v1-4-moat-tagger-v2onnx

- wd-v1-4-moat-tagger-v2csv字典

三十一、TripoSR模型

TripoSR 是由 Stability AI 和 Tripo AI 合作开发的快速前馈 3D 生成模型。

三十二、AnimateDiff模型

1、Motion modules模型

2、Motion LoRAs模型

- v2_lora_PanLeftckpt

- v2_lora_PanRightckpt

- v2_lora_RollingAnticlockwiseckpt

- v2_lora_RollingClockwiseckpt

- v2_lora_TiltDownckpt

- v2_lora_TiltUpckpt

- v2_lora_ZoomInckpt

- v2_lora_ZoomOutckpt

三十三、InsightFace模型

InsightFace是一个开源的2D&3D深度人脸分析工具箱,主要基于PyTorch和MXNet。

1、inswapper模型

2、buffalo_l模型

InsightFace 发布的 buffalo_l 面部检测和识别模型

三十四、IC-Light模型

IC-Light全称“Imposing Consistent Light”,是一个操纵图像照明的项目

三十五、RMBG模型

RMBG 是我们最先进的背景去除模型,旨在有效地将各种类别和图像类型的前景与背景分开。

三十六、SUPIR模型

模型实操案例:ComfyUI 模糊图像变清晰

三十七、BiRefNet模型

目前较好用的开源可商用背景抠除模型

- CODsafetensors一种用于隐蔽目标检测(COD)的预训练模型。

- DISsafetensors一种用于二分图像分割(DIS)的预训练模型。

- DIS-TR_TEssafetensorsafetensors具有大量数据集的预训练模型。

- Generalsafetensors用于一般用例的预训练模型。

- General-Litesafetensors用于一般用例的轻量级预训练模型。

- General-Lite-2Ksafetensors用于一般用例的轻量级预训练模型,适用于高分辨率图像。 (最佳分辨率2560x1440)

- HRSODsafetensors一种用于高分辨率显著目标检测(HRSOD)的预训练模型。

- Mattingsafetensors一种使用无trimap matting的预训练模型。

- Portraitsafetensors人物肖像预训练模型。

- birefnet-v1-liteonnx

模型实操案例:ComfyUI 一键抠图

三十八、CatVTON模型

模型实操案例:ComfyUI 一键换装

三十九、Redux模型

FLUX Redux 是用于生成图像变化的所有 FLUX基础模型的适配器。给定一个输入图像,FLUX Redux 可以重现略有变化的图像,从而可以细化给定的图像。

模型实操案例:ComfyUI 一键换装

四十、MODNet模型

MODNet 是一个仅使用 RGB 图像输入的实时人像抠图模型

模型实操案例:ComfyUI 证件照制作

四十一、retinaface模型

离线人脸检测模型

四十二、PuLID模型

面部保持技术。Pure and Lightning ID Customization via Contrastive Alignment(通过对比对齐实现 Pure 和 Lightning ID 定制)

1、SD15版本PuLID模型

2、SDXL版本PuLID模型

3、FLUX版本PuLID模型

模型实操案例:ComfyUI 制作个人头像

四十三、facexlib模型

facexlib是一个基于 pytorch 的面部相关功能库,例如检测、对齐、识别、跟踪、面部恢复工具等。它仅提供推理(不提供训练)。

模型实操案例:ComfyUI 制作个人头像

四十四、BOPBTL 模型

老照片修复技术

模型实操案例:ComfyUI 老照片修复

四十五、Florence-2模型

Florence-2 是一种先进的视觉基础模型,它使用基于提示的方法来处理各种视觉和视觉语言任务。Florence-2 可以解释简单的文本提示来执行字幕、对象检测和分割等任务。

四十六、Dlib模型

人脸检测模型

四十七、Makeup模型

美妆迁移模型

- mobilenet025_Finalpth

- pytorch_modelbin

- pytorch_model_1bin

- pytorch_model_2bin

- resnet50pth

- spiga_300wpublicpt

模型实操案例:ComfyUI 美妆迁移

四十八、LTX-Video 视频模型

LTX-Video 是第一个基于 DiT 的视频生成模型,能够实时生成高质量视频。它以 768x512 的分辨率生成 24 FPS 的视频,速度比观看速度更快。该模型在包含各种视频的大规模数据集上进行训练,可生成内容逼真、内容多样的高分辨率视频。我们为文本转视频以及图像+文本转视频用例提供了模型

模型实操案例:4-39 ComfyUI 文生视频与图生视频

四十九、WAN 视频模型

阿里巴巴旗下开源视频生成模型通义万相模型

模型实操案例:4-39 ComfyUI 文生视频与图生视频

五十、Depth-Anything-V2模型

- depth_anything_v2_vitspth

- depth_anything_v2_vitbpth

- depth_anything_v2_vitlpth

- depth_anything_v2_vitgpth

五十一、MimicMotion模型

模型实操案例:4-42 MimicMotion 小姐姐跳舞视频制作

五十二、DWPose模型

模型实操案例:4-42 MimicMotion 小姐姐跳舞视频制作

五十三、sonic模型

- 模型安装包:sonic模型

下载链接包含以下文件

模型实操案例:4-43 ComfyUI 数字人制作

五十四、TopazVideoAI模型

TopazVideoAI模型是用在TopazVideoAI软件中对视频进行放大、细节添加、帧差值等相关视频处理的模型

- 模型安装包:TopazVideoAI模型

模型实操案例:4-44 ComfyUI 视频放大

五十五、RVM模型

RVM 专为鲁棒的人体视频抠图而设计。与将帧作为独立图像处理的现有神经模型不同,RVM 使用循环神经网络来处理具有时间记忆的视频。RVM 可以在任何视频上实时执行抠图,而无需额外输入。

模型实操案例:4-45 ComfyUI 视频抠图

五十六、ProPainter模型

ProPainter:改进视频修复的传播和变换器

模型实操案例:4-46 ComfyUI 视频去水印与物体抹除